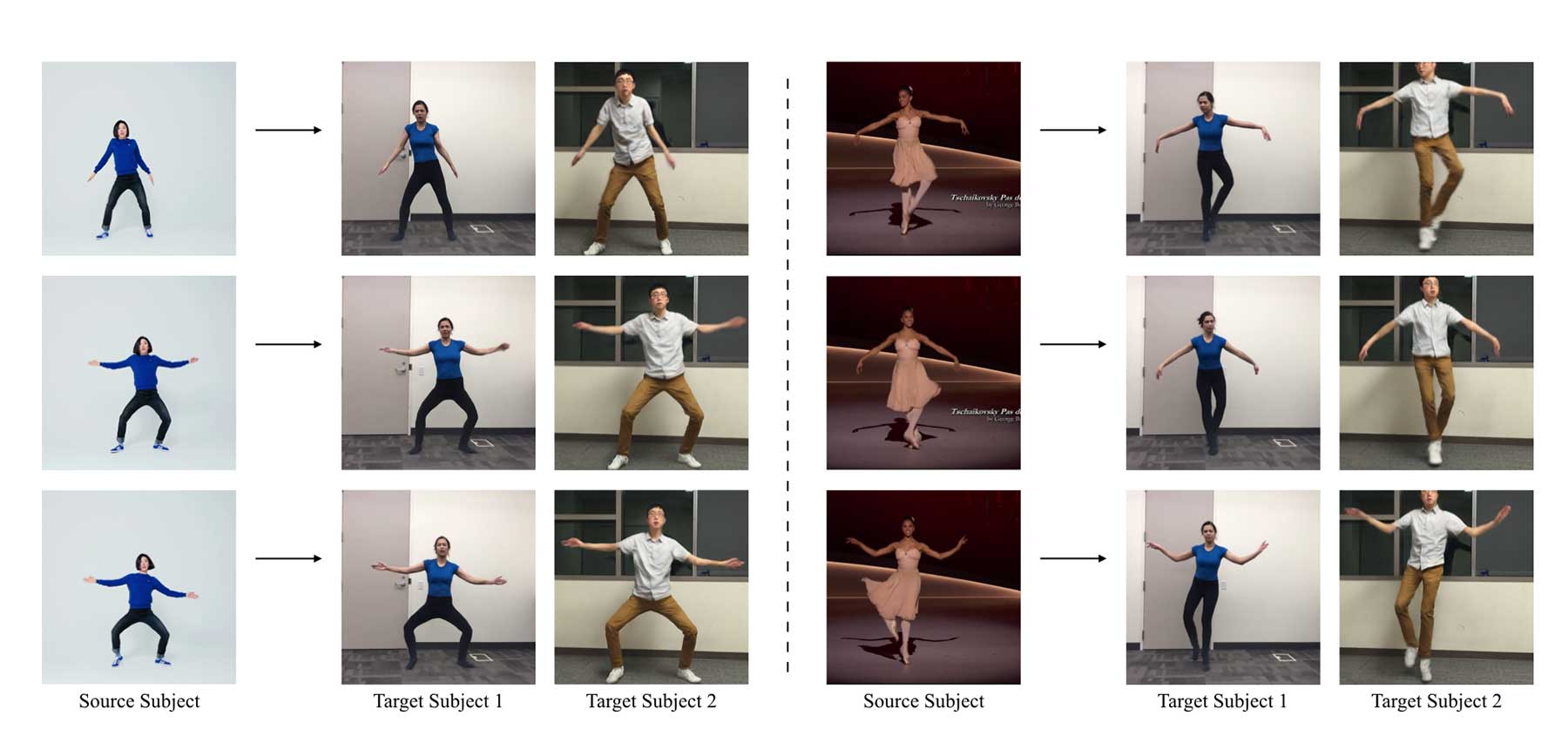

Caroline Chan, Shiry Ginosar, Tinghui Zhou und Alexei A. Efros von der University Berkeley liefern mit „Everybody Dance Now“ nicht nur ein interessantes wissenschaftliches Paper ab, sondern auch Hoffnung für alle Bewegungslegastheniker, deren Tanzstil sich auf Fuß- und Kopfwippen beschränkt. Denn in ihrem technischen Versuchsaufbau hilft eine künstliche Intelligenz dabei, Bewegungsabläufe einer Tänzer-Vorlage möglichst genau nachzubilden. Dabei sollte man zumindest grob die Bewegungen nachahmen, den Rest erledigt der Computer. Schaut natürlich noch rudimentär und nicht wirklich rund aus, ist aber schon ziemlich beeindruckend.

„This paper presents a simple method for ‚do as I do‘ motion transfer: given a source video of a person dancing we can transfer that performance to a novel (amateur) target after only a few minutes of the target subject performing standard moves. We pose this problem as a per-frame image-to-image translation with spatio-temporal smoothing. Using pose detections as an intermediate representation between source and target, we learn a mapping from pose images to a target subject’s appearance. We adapt this setup for temporally coherent video generation including realistic face synthesis.“

Mehr zum Projekt gibt es hier zu sehen, das komplette Paper kann man hier anschauen und herunterladen.

Noch keine Kommentare